摘要: 文章探討了AI驅(qū)動的運維工具從傳統(tǒng)整合到智能化的演進,分析了其核心技術(shù)與未來趨勢。運維工具從煙囪式建設(shè)到平臺化整合,再到智能化階段,逐步實現(xiàn)了從被動響應(yīng)到主動賦能的跨越。智能化運維(AIOps)通過大模型(LLM)和Agent技術(shù),推動運維從“自動化”向“自主化”演進,顯著提升了運維效率。

智能化運維的核心技術(shù)包括大模型的語義理解、復(fù)雜推理和多模態(tài)交互能力,推動了運維系統(tǒng)的主動預(yù)測和自主決策。其三大技術(shù)支柱為開發(fā)框架(如LangChain)、知識管理(向量數(shù)據(jù)庫與知識圖譜)和工具交互協(xié)議(MCP協(xié)議)。基于MCP協(xié)議的Agent驅(qū)動能力建設(shè)包括工具改造、智能體開發(fā)和生態(tài)構(gòu)建,通過標(biāo)準(zhǔn)化接口和多模態(tài)交互,重構(gòu)了運維工具鏈的連接方式。

01.運維工具發(fā)展的演進路徑

運維工具的建設(shè)歷程反映了企業(yè)數(shù)字化轉(zhuǎn)型的技術(shù)需求變遷。從早期“煙囪式”分散建設(shè)到平臺化整合,再到當(dāng)前以AI為核心的智能化階段,運維體系逐步實現(xiàn)了從被動響應(yīng)到主動賦能的跨越。

1)煙囪化建設(shè)階段:工具孤島與效率瓶頸

在信息化初期,運維依賴人工操作和定制化腳本,形成了以業(yè)務(wù)系統(tǒng)為中心的“煙囪式”工具鏈。例如,網(wǎng)絡(luò)監(jiān)控、日志分析、配置管理等場景均需獨立開發(fā)工具,導(dǎo)致數(shù)據(jù)孤島、重復(fù)開發(fā)和運維人員技能碎片化。此階段的核心矛盾在于工具間缺乏標(biāo)準(zhǔn)化接口,運維效率受限于人工協(xié)調(diào)與知識傳遞成本。

2)平臺化建設(shè)階段:API驅(qū)動的統(tǒng)一治理

為解決工具碎片化問題,企業(yè)開始構(gòu)建運維平臺(如騰訊藍鯨、阿里云運維平臺),通過API Gateway整合異構(gòu)工具,形成標(biāo)準(zhǔn)化操作入口。例如,騰訊藍鯨通過運維PaaS平臺實現(xiàn)自動化腳本編排、任務(wù)調(diào)度和跨團隊協(xié)作,將運維操作效率提升300%以上。此階段的關(guān)鍵特征包括:

- 工具抽象:將監(jiān)控工具、配置管理工具等封裝為統(tǒng)一接口;

- 流程標(biāo)準(zhǔn)化:通過可視化編排工具(如Argo Workflows)實現(xiàn)復(fù)雜任務(wù)自動化;

- 數(shù)據(jù)集中化:構(gòu)建統(tǒng)一的可觀測數(shù)據(jù)平臺,整合日志、指標(biāo)、事件等多維度數(shù)據(jù)。

然而,平臺化仍存在局限:工具調(diào)用依賴人工配置,難以適應(yīng)動態(tài)變化的運維場景;同時,傳統(tǒng)運維平臺以規(guī)則引擎為主,缺乏對復(fù)雜問題的推理能力。

3)智能化建設(shè)階段:Agent驅(qū)動的自主運維

智能化運維(AIOps)通過引入大模型(LLM)和Agent技術(shù),推動運維從“自動化”向“自主化”演進。其核心目標(biāo)是通過AI代理自主完成故障診斷、資源調(diào)度、變更決策等任務(wù),實現(xiàn)“零接觸”運維。例如,字節(jié)跳動通過大模型Agent將故障自愈率提升至85%,人工干預(yù)時間減少70%。

02.智能化建設(shè)的核心技術(shù)支撐

大模型技術(shù)(LLM)的突破性發(fā)展為運維領(lǐng)域帶來了革命性變革。其核心優(yōu)勢在于語義理解能力、復(fù)雜推理能力和多模態(tài)交互能力,這些特性使得運維系統(tǒng)從被動響應(yīng)轉(zhuǎn)向主動預(yù)測與自主決策。

1)數(shù)據(jù)處理能力的質(zhì)變

傳統(tǒng)運維依賴規(guī)則引擎和關(guān)鍵詞匹配分析日志,而大模型通過自然語言處理(NLP)技術(shù),可直接解析日志中的語義信息。例如,華為基于大小模型協(xié)同的運維系統(tǒng),通過專用小模型處理已知問題,大模型則負責(zé)多源數(shù)據(jù)關(guān)聯(lián)分析,將故障定位時間縮短至分鐘級。在數(shù)據(jù)處理架構(gòu)上,大模型與向量數(shù)據(jù)庫(如Milvus)結(jié)合,構(gòu)建了“數(shù)據(jù)-知識-決策”閉環(huán)。通過RAG技術(shù),運維知識庫可動態(tài)更新,支持故障案例的跨場景復(fù)用。例如,螞蟻集團的Mpilot智能助手,利用Ceresdb時序數(shù)據(jù)庫和知識檢索能力,實現(xiàn)告警根因定位準(zhǔn)確率92%。

2)故障預(yù)測與診斷的智能化

大模型通過時序數(shù)據(jù)分析和模式識別,可提前預(yù)測潛在故障。以服務(wù)器資源監(jiān)控為例,大模型可同時處理CPU、內(nèi)存、磁盤I/O等多維度指標(biāo),構(gòu)建時序預(yù)測模型。某云服務(wù)商的實驗顯示,基于TensorFlow構(gòu)建的預(yù)測模型,使CPU過載預(yù)警準(zhǔn)確率達89%,資源調(diào)整響應(yīng)時間從小時級降至分鐘級。

在故障診斷場景中,大模型Agent通過多模態(tài)數(shù)據(jù)融合(日志、指標(biāo)、拓撲)生成根因分析報告。例如,字節(jié)跳動的智能運維系統(tǒng),結(jié)合視覺Agent解析設(shè)備面板圖,自動識別硬件故障并生成修復(fù)方案,自愈率提升至85%。

3)自動化與自主決策的突破

大模型驅(qū)動的Agent具備動態(tài)規(guī)劃能力和工具調(diào)用能力。以部署任務(wù)為例,運維人員通過自然語言描述需求(如“在測試環(huán)境部署Web應(yīng)用并驗證數(shù)據(jù)庫連接”),大模型可自動生成Ansible腳本并執(zhí)行,錯誤率較人工操作下降70%。

在復(fù)雜決策場景中,規(guī)劃Agent利用LLM的反思機制(ReAct算法)生成多步操作計劃。例如,跨區(qū)域容災(zāi)場景中,規(guī)劃Agent可協(xié)調(diào)多地執(zhí)行Agent,通過MCP協(xié)議同步操作日志和狀態(tài),實現(xiàn)分鐘級故障切換。

智能化運維的實現(xiàn)依賴于三大技術(shù)支柱:開發(fā)框架、知識管理、工具交互協(xié)議。它們共同構(gòu)建了一個高效、智能、可擴展的運維生態(tài)系統(tǒng),為企業(yè)提供了從問題發(fā)現(xiàn)到解決的全流程自動化能力。以下將對這三項核心技術(shù)進行詳細的解析,結(jié)合實際案例說明其在智能化運維中的具體應(yīng)用與價值。

4)開發(fā)框架:LangChain與智能體工程

LangChain作為開源的LLM應(yīng)用開發(fā)框架,為智能化運維提供了模塊化、可擴展的開發(fā)范式。它通過將復(fù)雜的運維任務(wù)分解為多個可執(zhí)行的子任務(wù),并利用計劃模塊、記憶管理和工具調(diào)用等功能,實現(xiàn)了從問題發(fā)現(xiàn)到解決的自動化流程。LangChain的靈活性和開放性使其成為智能化運維開發(fā)的首選框架。

(1)計劃模塊:動態(tài)規(guī)劃與多步推理

計劃模塊是LangChain的核心組件之一,專注于任務(wù)分解與流程規(guī)劃。通過引入ReAct(Reasoning + Acting)和Self-Ask等推理算法,計劃模塊能夠動態(tài)生成多步操作計劃。

- ReAct算法:ReAct通過交互式推理與行動的結(jié)合,實現(xiàn)了智能體的認知推理能力。例如,在根因定位場景中,ReAct算法會先生成一個診斷計劃,比如“檢查日志中是否有異常模式→篩選出特定時間段的告警→關(guān)聯(lián)相關(guān)服務(wù)的配置變更”,并逐一執(zhí)行這些步驟,最終得出問題的根本原因。

- Self-Ask算法:Self-Ask通過自問自答的方式,逐步細化任務(wù)需求。例如,當(dāng)檢測到某個服務(wù)器的CPU使用率異常時,智能體會自動生成問題:“是由于高負載任務(wù)還是資源不足?”并通過后續(xù)步驟驗證假設(shè),生成最終操作建議。

以某企業(yè)基于LangChain構(gòu)建的HDFS集群診斷Agent為例,其計劃模塊能夠在3分鐘內(nèi)完成以下任務(wù):

- 問題識別:通過Prometheus監(jiān)控數(shù)據(jù),自動識別出導(dǎo)致集群性能下降的異常節(jié)點;

- 日志分析:調(diào)用Elasticsearch查詢相關(guān)日志,提取異常模式;

- 故障復(fù)原:生成修復(fù)方案(如重啟失敗的節(jié)點或重新分配任務(wù)),并提交給執(zhí)行Agent完成操作。

該Agent的根因定位準(zhǔn)確率達到92%,極大地提升了運維效率,減少了人工干預(yù)時間。

(2)記憶管理:長時記憶與知識復(fù)用

LangChain的記憶管理組件通過結(jié)合檢索增強生成(RAG)技術(shù),構(gòu)建了一個長期記憶庫,用于存儲和復(fù)用歷史故障案例和解決方案。

- RAG技術(shù):RAG(Retrieval-Augmented Generation)通過在生成過程中動態(tài)檢索相關(guān)信息,增強了模型的上下文理解和生成能力。例如,在處理類似的歷史故障時,記憶管理模塊可以從歷史案例庫中檢索相似的情境,并為當(dāng)前的診斷任務(wù)提供參考。

- 跨場景復(fù)用:通過記憶管理,智能體能夠?qū)⒛骋粓鼍暗某晒鉀Q方案遷移到其他類似場景。例如,某數(shù)據(jù)庫性能優(yōu)化案例中的SQL索引調(diào)整方案,可以被復(fù)用到另一個數(shù)據(jù)庫實例中,從而減少重復(fù)開發(fā)的工作量。

(3)工具調(diào)用:多工具協(xié)同與API集成

工具調(diào)用模塊通過封裝運維系統(tǒng)的API接口,實現(xiàn)了LLM與底層工具的無縫交互。LangChain支持多種工具的調(diào)用,包括監(jiān)控工具(如Prometheus)、配置管理工具(如Ansible)、自動化運維平臺(如Terraform)等。

- Prometheus集成:通過封裝Prometheus的查詢接口,智能體可以實時獲取系統(tǒng)的性能指標(biāo),如CPU使用率、內(nèi)存占用等。例如,當(dāng)系統(tǒng)告警觸發(fā)時,智能體可以調(diào)用Prometheus查詢“近5分鐘內(nèi)CPU使用率超過90%的實例”,并結(jié)合日志分析定位問題。

- Ansible自動化:通過封裝Ansible的Playbook接口,智能體可以自動生成和執(zhí)行配置變更腳本,從而實現(xiàn)快速修復(fù)。例如,某企業(yè)通過LangChain構(gòu)建的自動擴縮容Agent,可在高峰期自動擴容3臺ECS實例,并在低峰期釋放資源,節(jié)省了30%的運營成本。

通過這些功能,LangChain為智能化運維提供了一個強大的開發(fā)框架,使運維任務(wù)的自動化和智能化成為可能。

5)知識管理:向量數(shù)據(jù)庫與知識圖譜

知識管理是智能化運維的基石,其核心目標(biāo)是實現(xiàn)運維知識的存儲、檢索和推演。向量數(shù)據(jù)庫和知識圖譜作為知識管理的核心工具,通過語義檢索和知識增強技術(shù),為運維場景提供了強大的支持。

(1)語義檢索:從非結(jié)構(gòu)化數(shù)據(jù)到智能查詢

向量數(shù)據(jù)庫(如Milvus、Chroma)通過向量化技術(shù),將日志、告警、網(wǎng)頁等非結(jié)構(gòu)化數(shù)據(jù)轉(zhuǎn)化為高維向量,并支持基于相似度的自然語言查詢。

- 自然語言查詢:通過嵌入向量技術(shù),運維人員可以用自然語言直接查詢系統(tǒng)狀態(tài)。例如,“查找近7天CPU使用率超過90%的實例”這一查詢請求會被轉(zhuǎn)化為一組嵌入向量,向量數(shù)據(jù)庫會通過相似度計算快速返回相關(guān)日志記錄。

- 跨維度分析:向量數(shù)據(jù)庫支持多維度數(shù)據(jù)的聯(lián)合分析。例如,運維人員可以通過一個查詢語句同時獲取“CPU使用率、內(nèi)存占用和網(wǎng)絡(luò)流量”的趨勢數(shù)據(jù),從而更全面地分析系統(tǒng)性能。

某金融企業(yè)引入向量數(shù)據(jù)庫后,故障定位時間從小時級縮短至分鐘級,誤報率下降60%。例如,通過向量化技術(shù),該企業(yè)成功實現(xiàn)了對分布式系統(tǒng)中“雪崩效應(yīng)”的實時監(jiān)控和預(yù)警。

(2)知識增強:AI驅(qū)動的領(lǐng)域知識庫

知識增強模塊通過主動學(xué)習(xí)技術(shù),持續(xù)優(yōu)化模型對領(lǐng)域知識的理解。例如,當(dāng)新型攻擊模式出現(xiàn)時,知識增強模塊會自動提取相關(guān)日志和告警信息,生成新的知識圖譜節(jié)點,并更新現(xiàn)有知識庫。

- 模式識別:通過分析歷史攻擊日志,知識增強模塊可以識別新型攻擊模式的特征。例如,某企業(yè)通過知識增強模塊發(fā)現(xiàn)了一種“低頻高持久性”的API濫用攻擊,并生成了相應(yīng)的防護策略。

- 自動化學(xué)習(xí):知識增強模塊支持自動化學(xué)習(xí),無需人工干預(yù)即可更新知識庫。例如,當(dāng)檢測到某種新型漏洞時,知識增強模塊會自動生成修復(fù)方案,并推送給執(zhí)行Agent。

6)工具交互協(xié)議:MCP協(xié)議與生態(tài)構(gòu)建

MCP(Model Context Protocol,模型上下文協(xié)議)是由Anthropic公司于2024年11月提出的開放協(xié)議,旨在標(biāo)準(zhǔn)化大型語言模型(LLM)與外部數(shù)據(jù)源、工具及服務(wù)的交互方式,解決AI模型與實時數(shù)據(jù)隔離的痛點。在運維工具和智能運維場景的建設(shè)中,應(yīng)用MCP可以通過標(biāo)準(zhǔn)化接口、多模態(tài)交互和安全隔離,重構(gòu)了運維工具鏈的連接方式。

(1)標(biāo)準(zhǔn)化接口:統(tǒng)一調(diào)用范式

MCP協(xié)議通過定義統(tǒng)一的工具調(diào)用接口,避免了“每個模型×每個工具”的重復(fù)開發(fā)。例如,運維人員可以通過MCP協(xié)議調(diào)用Prometheus、Ansible、Terraform等工具,而無需為每個工具開發(fā)特定的適配模塊。

- Prometheus集成:通過MCP協(xié)議,智能體可以動態(tài)調(diào)整Prometheus的告警規(guī)則。例如,運維人員可以通過自然語言指令(如“將數(shù)據(jù)庫查詢延遲的告警閾值調(diào)整為200ms”)完成配置,而無需編寫PromQL腳本。

- Ansible自動化:MCP協(xié)議支持Ansible任務(wù)的動態(tài)生成與執(zhí)行。例如,運維人員可以通過自然語言指令(如“為所有Web服務(wù)器安裝最新補丁”)生成Ansible Playbook,并自動分發(fā)執(zhí)行。

(2)多模態(tài)交互:自然語言與API的橋梁

MCP協(xié)議支持自然語言指令與結(jié)構(gòu)化API的自動轉(zhuǎn)換。例如,當(dāng)運維人員輸入“擴容3臺EC2實例”時,MCP協(xié)議會自動將其轉(zhuǎn)化為Terraform的API調(diào)用,并完成資源分配。

03.基于MCP協(xié)議的Agent驅(qū)動能力建設(shè)

MCP(Model Context Protocol)協(xié)議作為智能化運維的“操作系統(tǒng)”,為分布式、復(fù)雜和動態(tài)的運維場景提供了標(biāo)準(zhǔn)化、高效化的工具鏈連接方式。它通過協(xié)議適配、多智能體協(xié)作和生態(tài)共建,構(gòu)建了一個開放、可擴展的運維能力框架。其實施路徑可分為三個階段: 工具改造、智能體開發(fā)和生態(tài)構(gòu)建。以下將詳細闡述每個階段的實施細節(jié)、技術(shù)要點和實際應(yīng)用價值。

1)工具改造:協(xié)議適配與能力封裝

工具改造是MCP協(xié)議落地的第一步,其核心目標(biāo)是實現(xiàn)“MCP Server”,使各類運維工具能夠兼容MCP協(xié)議并通過MCP接口提供服務(wù)。這一階段的實施包括以下三個關(guān)鍵步驟:

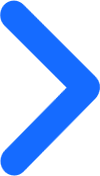

(1)接口定義:工具功能的標(biāo)準(zhǔn)化描述

在工具改造中, 接口定義是基礎(chǔ)。通過使用OpenAPI規(guī)范,工具的功能可以被標(biāo)準(zhǔn)化描述。OpenAPI規(guī)范通過YAML或JSON格式定義工具的API接口,包括接口路徑、請求參數(shù)、返回值格式等。這種標(biāo)準(zhǔn)化使得不同工具的功能能夠被統(tǒng)一的客戶端調(diào)用。

示例:

通過上述標(biāo)準(zhǔn)化接口描述,運維人員可以通過MCP協(xié)議統(tǒng)一調(diào)用工具功能,而無需了解工具的具體實現(xiàn)細節(jié)。

(2)協(xié)議封裝:工具操作的MCP化

協(xié)議封裝是將工具的原始操作接口封裝為MCP協(xié)議兼容的接口,從而實現(xiàn)對工具的高效調(diào)用。協(xié)議封裝的核心在于將工具的接口邏輯轉(zhuǎn)化為任務(wù)調(diào)度的標(biāo)準(zhǔn)化流程。

示例:

- Ansible Playbook的封裝:Ansible Playbook原本需要編寫YAML文件并通過命令行執(zhí)行,而通過MCP協(xié)議封裝后,用戶只需通過自然語言描述“為新服務(wù)器部署Nginx應(yīng)用”,即可自動生成Playbook并執(zhí)行。

- 數(shù)據(jù)庫遷移工具:原本需要手動輸入SQL語句或腳本,封裝后可通過MCP接口直接調(diào)用“數(shù)據(jù)庫遷移任務(wù)”,用戶只需提供源和目標(biāo)數(shù)據(jù)庫的連接信息。

通過協(xié)議封裝,運維人員可以使用自然語言指令完成復(fù)雜操作,而無需關(guān)心底層工具的實現(xiàn)細節(jié)。

(3)安全增強:訪問控制與審計

為確保工具的安全性,MCP協(xié)議在工具改造過程中需要集成訪問控制列表(ACL) 和審計日志。

- 訪問控制列表(ACL) :通過定義用戶權(quán)限,確保只有授權(quán)用戶可以訪問特定工具。例如,某個工具的管理員權(quán)限用戶可以執(zhí)行“擴容任務(wù)”,而普通用戶只能查看資源狀態(tài)。

- 審計日志:記錄每次工具調(diào)用的詳細信息,包括調(diào)用時間、調(diào)用用戶、操作結(jié)果等。

2)智能體開發(fā):多Agent協(xié)作與流程編排

基于MCP協(xié)議的智能體架構(gòu)為運維場景提供了高度自動化和動態(tài)化的能力。智能體架構(gòu)通常由以下三類角色組成:

(1)規(guī)劃Agent:任務(wù)執(zhí)行計劃生成

規(guī)劃Agent是智能體的“大腦”,負責(zé)根據(jù)用戶需求生成任務(wù)執(zhí)行計劃。規(guī)劃Agent通常基于LLM(大語言模型)實現(xiàn),利用ReAct算法(Reasoning + Acting)或Self-Ask算法動態(tài)生成任務(wù)步驟。

應(yīng)用場景:

- 故障自愈:當(dāng)系統(tǒng)發(fā)生故障時,規(guī)劃Agent會分析故障描述、日志和指標(biāo)數(shù)據(jù),生成多步操作計劃。例如,“檢查數(shù)據(jù)庫連接→驗證日志中的異常模式→重啟故障實例”。

- 資源擴容:當(dāng)檢測到資源不足時,規(guī)劃Agent會生成擴容計劃,包括需要擴容的服務(wù)器數(shù)量、目標(biāo)地域等信息。

(2)執(zhí)行Agent:工具調(diào)用的執(zhí)行者

執(zhí)行Agent是智能體的“執(zhí)行器”,通過MCP協(xié)議調(diào)用工具完成任務(wù)。執(zhí)行Agent需要與多種運維工具對接,支持跨工具協(xié)作。

示例:

- 云資源管理:執(zhí)行Agent可以調(diào)用Terraform插件,通過MCP協(xié)議完成云資源的創(chuàng)建和銷毀任務(wù)。

- 容器管理:執(zhí)行Agent可以調(diào)用Kubernetes插件,通過MCP協(xié)議完成Pod的擴容、縮容或重啟操作。

(3)監(jiān)控Agent:任務(wù)狀態(tài)的實時跟蹤

監(jiān)控Agent負責(zé)實時跟蹤任務(wù)狀態(tài),并在任務(wù)執(zhí)行過程中動態(tài)調(diào)整策略。例如,在跨區(qū)域容災(zāi)場景中,當(dāng)某個區(qū)域的網(wǎng)絡(luò)連接異常時,監(jiān)控Agent會通知規(guī)劃Agent調(diào)整任務(wù)計劃,將資源遷移到其他區(qū)域。

在跨區(qū)域容災(zāi)場景中,三類Agent的協(xié)作流程如下:

- 監(jiān)控Agent發(fā)現(xiàn)故障:監(jiān)控Agent實時檢測到某區(qū)域的網(wǎng)絡(luò)延遲異常;

- 規(guī)劃Agent生成任務(wù)計劃:規(guī)劃Agent生成遷移方案,包括需要遷移的實例和服務(wù);

- 執(zhí)行Agent完成遷移:執(zhí)行Agent通過MCP協(xié)議調(diào)用Terraform插件,完成資源遷移;

- 監(jiān)控Agent驗證遷移結(jié)果:監(jiān)控Agent驗證遷移后的網(wǎng)絡(luò)延遲恢復(fù)正常,任務(wù)結(jié)束。

通過三類Agent的協(xié)作,運維任務(wù)可以在分鐘級完成,極大提高了系統(tǒng)的可靠性。

3)生態(tài)構(gòu)建:插件市場與開發(fā)者社區(qū)

MCP協(xié)議的開放性為開發(fā)者提供了廣闊的生態(tài)建設(shè)空間,催生了豐富的工具生態(tài)和開發(fā)者社區(qū)。

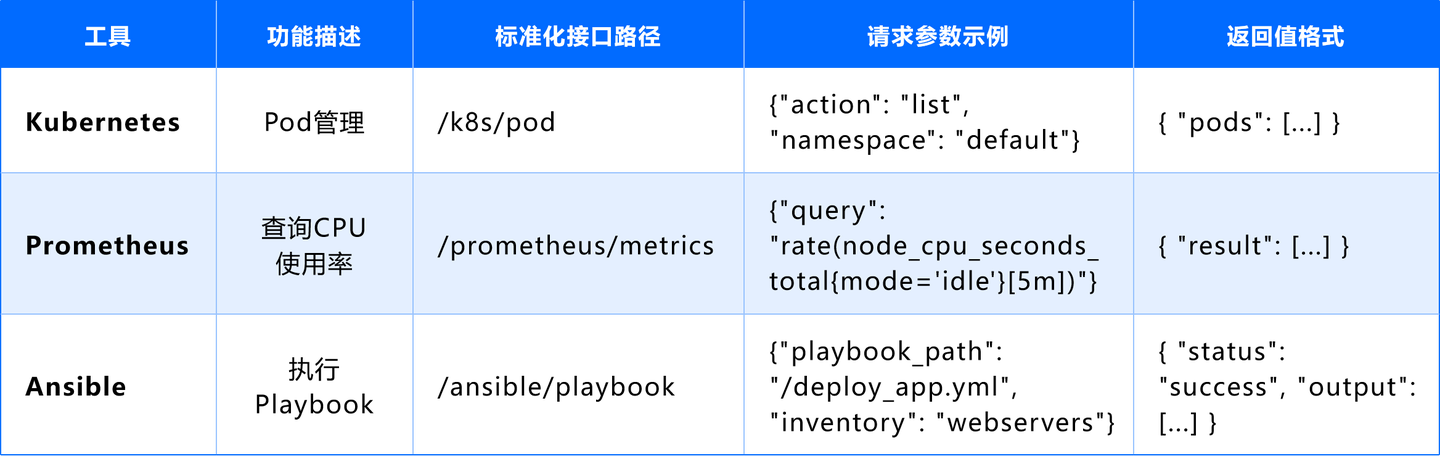

(1)插件市場:MCP協(xié)議的插件化生態(tài)

MCP協(xié)議的開放性使得開發(fā)者可以快速開發(fā)適配不同運維需求的插件,從而構(gòu)建一個插件化生態(tài)。以下是部分典型插件的功能描述:

- Sentry MCP:通過分析應(yīng)用崩潰日志和用戶行為數(shù)據(jù),自動歸因故障原因并生成修復(fù)建議。例如,當(dāng)應(yīng)用崩潰時,Sentry MCP可以識別出是由于某一特定API的輸入驗證失敗導(dǎo)致的問題,并建議修復(fù)該API的驗證邏輯。

- Cline插件市場:提供200+預(yù)置插件,支持AWS、Azure等云服務(wù)的一鍵對接。例如,運維人員可以通過插件市場快速集成AWS的ECS服務(wù),通過MCP協(xié)議實現(xiàn)容器的自動化部署和擴容。

04.挑戰(zhàn)與未來趨勢

MCP(Model Context Protocol)協(xié)議作為智能化運維的核心支撐技術(shù),通過標(biāo)準(zhǔn)化接口和智能化交互,顯著提升了運維工具鏈的效率和自動化水平。然而,隨著MCP協(xié)議的廣泛應(yīng)用,生態(tài)兼容性、性能優(yōu)化和安全性等問題逐漸成為挑戰(zhàn),亟需通過技術(shù)創(chuàng)新和標(biāo)準(zhǔn)制定來解決。同時,隨著多模態(tài)交互和跨平臺協(xié)作的技術(shù)發(fā)展,MCP協(xié)議正朝著更加智能化、開放化和聯(lián)邦化的方向演進。

1)面臨的挑戰(zhàn)

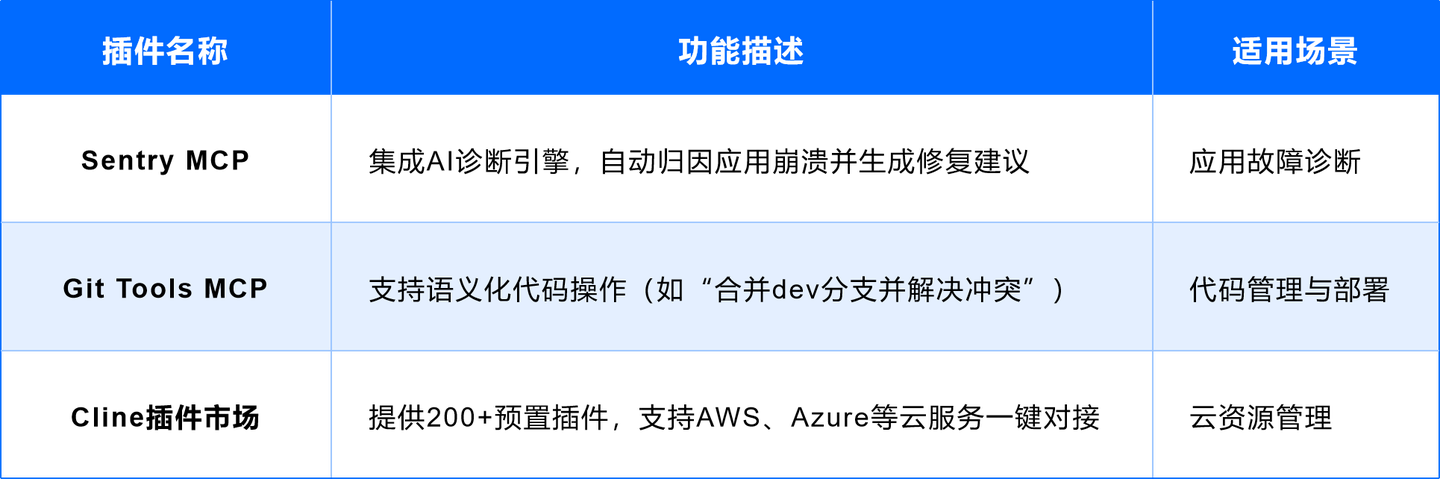

(1)生態(tài)兼容性:模型與協(xié)議的適配難題

MCP協(xié)議的核心價值在于統(tǒng)一工具調(diào)用接口,但不同廠商的LLM(大語言模型)在實現(xiàn)方式、推理能力、輸入輸出格式等方面存在顯著差異,導(dǎo)致對MCP協(xié)議的支持程度不一。這種差異主要體現(xiàn)在以下方面:

- 輸入格式的差異:部分廠商的LLM要求輸入為純文本格式,而另一些廠商可能支持嵌入向量(embedding)或多模態(tài)輸入(如圖像、音頻)。這種差異會導(dǎo)致MCP協(xié)議在調(diào)用模型時需要進行額外的適配和轉(zhuǎn)換。

- 輸出解析的多樣性:不同LLM的輸出格式和語義理解能力可能存在差異,例如某些模型返回的結(jié)果是JSON格式,而另一些模型則返回自然語言描述。這種不統(tǒng)一的輸出格式會增加MCP協(xié)議解析的復(fù)雜性。

- 推理能力的差異:某些LLM在多步推理(ReAct算法)和復(fù)雜任務(wù)規(guī)劃(Self-Ask算法)中表現(xiàn)較好,而另一些模型可能更擅長單步推理,導(dǎo)致在動態(tài)任務(wù)規(guī)劃場景中表現(xiàn)不佳。

為了應(yīng)對這些挑戰(zhàn),行業(yè)需要推動標(biāo)準(zhǔn)化測試套件的建設(shè),涵蓋以下內(nèi)容:

通過標(biāo)準(zhǔn)化測試套件,可以量化不同LLM對MCP協(xié)議的支持程度,為廠商開發(fā)和用戶選擇提供依據(jù)。

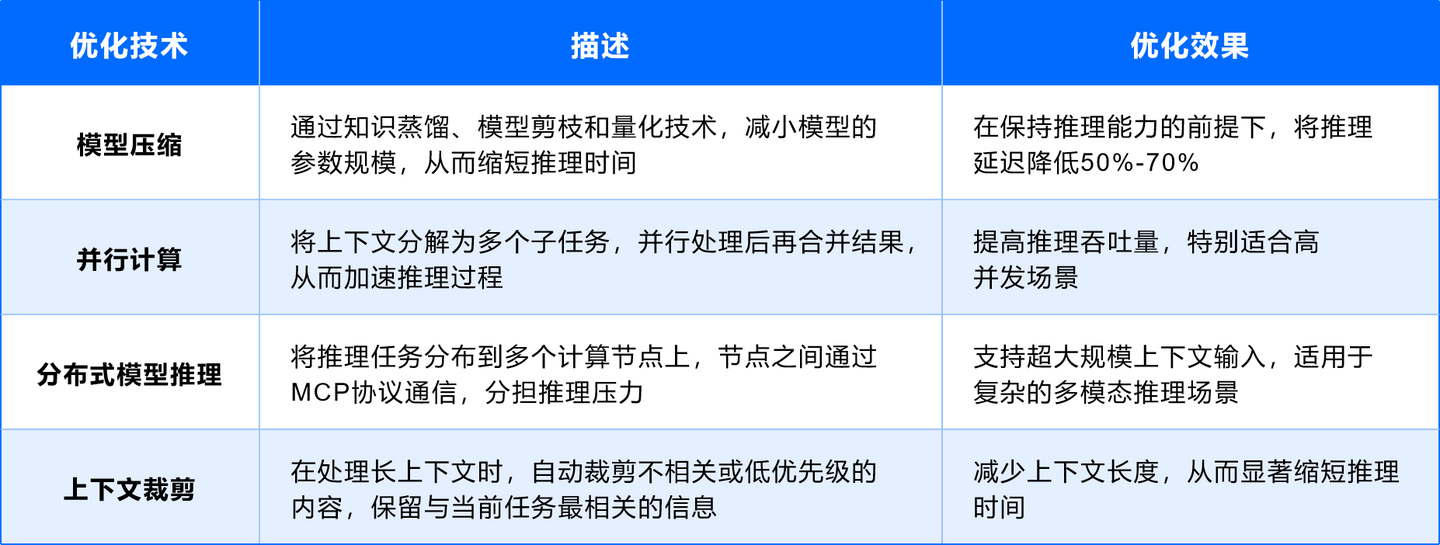

(2)性能優(yōu)化:長上下文對話的延遲問題

大語言模型在處理長上下文輸入時,推理延遲顯著增加。這對于需要動態(tài)響應(yīng)的運維場景(如故障診斷和自愈)是一個不容忽視的挑戰(zhàn)。

- 長上下文輸入的需求:在運維場景中,LLM需要同時處理來自日志、告警、監(jiān)控指標(biāo)和用戶指令的多模態(tài)輸入,這會導(dǎo)致輸入上下文長度顯著增加。例如,一個針對分布式系統(tǒng)的故障診斷任務(wù)可能需要結(jié)合1000行日志和50條告警信息作為輸入,這會導(dǎo)致模型推理時間顯著延長。

- 延遲增加的影響:延遲增加會降低運維系統(tǒng)的實時性,尤其是在高并發(fā)場景下,可能導(dǎo)致任務(wù)隊列積壓,影響系統(tǒng)穩(wěn)定性。

為應(yīng)對這一問題,智能運維工具建設(shè)需要結(jié)合以下技術(shù)進行優(yōu)化:

例如,通過上下文裁剪技術(shù),某企業(yè)成功將日志分析任務(wù)的推理時間從120秒縮短至30秒,顯著提升了故障診斷的實時性。

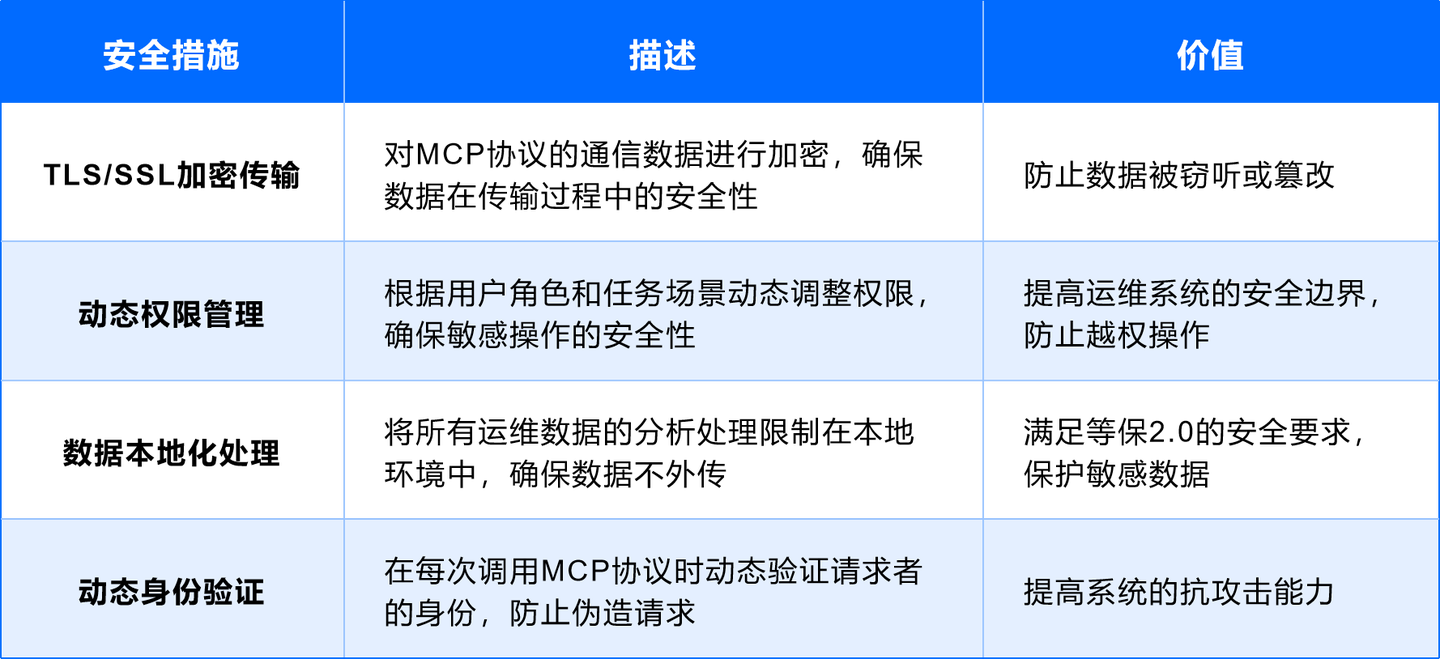

(3)安全邊界:零信任架構(gòu)的深度集成

MCP協(xié)議的本地化部署為其帶來了一定的安全性,但仍需與零信任架構(gòu)深度集成,以應(yīng)對復(fù)雜的生產(chǎn)環(huán)境中的潛在安全威脅。以下是主要的挑戰(zhàn)和應(yīng)對措施:

- 數(shù)據(jù)隔離與傳輸安全:在生產(chǎn)環(huán)境中,MCP協(xié)議需要處理敏感運維數(shù)據(jù)(如日志、監(jiān)控指標(biāo)、告警規(guī)則等),這些數(shù)據(jù)的傳輸和存儲需要加密保護。MCP協(xié)議需要支持TLS/SSL加密傳輸,確保數(shù)據(jù)在傳輸過程中不被截獲或篡改。

- 動態(tài)權(quán)限管理:MCP協(xié)議的調(diào)用權(quán)限需要根據(jù)用戶角色和場景動態(tài)調(diào)整。例如,管理員用戶可以調(diào)用“擴容”任務(wù),而普通用戶只能調(diào)用“查詢資源狀態(tài)”任務(wù)。

- 數(shù)據(jù)本地化與零信任集成:為了滿足等保2.0的要求,MCP協(xié)議需要將數(shù)據(jù)處理和分析限制在本地網(wǎng)絡(luò)中,確保敏感數(shù)據(jù)不外傳。同時,需要結(jié)合零信任架構(gòu),動態(tài)驗證每個請求的合法性。

例如,某企業(yè)通過將MCP服務(wù)器部署在私有云端,并結(jié)合零信任架構(gòu),成功實現(xiàn)了對運維數(shù)據(jù)的全面保護,未發(fā)生數(shù)據(jù)泄露事件。

2)未來趨勢

(1)多模態(tài)交互:運維場景的智能化升級

MCP協(xié)議的未來發(fā)展將顯著強化多模態(tài)交互能力,支持用戶通過自然語言、語音指令和視覺指令與MCP協(xié)議交互。以下是多模態(tài)交互的主要應(yīng)用場景:

- 自然語言交互:用戶通過自然語言描述需求,MCP協(xié)議自動解析并生成操作計劃。例如,“檢查數(shù)據(jù)庫的CPU使用率是否超過90%”會自動觸發(fā)Prometheus查詢和告警生成。

- 語音指令交互:在緊急情況下,運維人員可以通過語音指令快速觸發(fā)任務(wù)。例如,“將Web服務(wù)器的實例從2臺擴容到5臺”可以通過語音觸發(fā)MCP協(xié)議的執(zhí)行Agent完成任務(wù)。

- 視覺交互:通過視覺Agent解析運維網(wǎng)頁或監(jiān)控面板的內(nèi)容,提取關(guān)鍵信息并生成操作計劃。例如,視覺Agent可以解析某云服務(wù)提供商的控制臺界面,自動生成云資源的操作建議。

(2)跨平臺Agent聯(lián)邦:分布式協(xié)作的高效運維

MCP協(xié)議的開放性和跨平臺能力將催生Agent聯(lián)邦的興起。Agent聯(lián)邦通過多個MCP節(jié)點的協(xié)作,實現(xiàn)對分布式系統(tǒng)的統(tǒng)一運維。

- 聯(lián)邦架構(gòu):Agent聯(lián)邦由多個本地MCP節(jié)點組成,每個節(jié)點負責(zé)本地系統(tǒng)的運維任務(wù),同時通過MCP協(xié)議與其他節(jié)點通信,實現(xiàn)跨系統(tǒng)的協(xié)同操作。

- 多云協(xié)同運維:Agent聯(lián)邦可以支持多云環(huán)境的統(tǒng)一運維。例如,用戶可以通過一個MCP節(jié)點調(diào)度騰訊云和AWS的資源,實現(xiàn)跨云的自動化操作。

05.結(jié)語

AI驅(qū)動的運維平臺建設(shè),本質(zhì)是通過技術(shù)重構(gòu)實現(xiàn)運維能力的躍遷。從API驅(qū)動的平臺化到AI協(xié)議的智能化,每一步都需平衡效率與安全、標(biāo)準(zhǔn)化與靈活性。對于企業(yè)而言,構(gòu)建智能化運維體系不僅是技術(shù)升級,更是組織能力與文化轉(zhuǎn)型的契機——運維團隊需從“救火隊員”轉(zhuǎn)變?yōu)椤爸悄軟Q策者”。

06.附錄一:MCP協(xié)議的發(fā)展

MCP(Model Context Protocol,模型上下文協(xié)議)是由Anthropic公司于2024年11月提出的開放協(xié)議,旨在標(biāo)準(zhǔn)化大型語言模型(LLM)與外部數(shù)據(jù)源、工具及服務(wù)的交互方式,解決AI模型與實時數(shù)據(jù)隔離的痛點

1)核心架構(gòu)與工作流程

(1)客戶端-服務(wù)器架構(gòu)

- MCP Client:嵌入AI應(yīng)用(如Claude Desktop、IDE)的協(xié)議客戶端,負責(zé)與服務(wù)器建立1:1連接,管理請求路由和能力協(xié)商。

- MCP Server:輕量級程序,通過標(biāo)準(zhǔn)化接口暴露工具(Tools)、資源(Resources)和提示模板(Prompts),支持本地或遠程數(shù)據(jù)訪問249。

- 通信協(xié)議:基于JSON-RPC 2.0,支持標(biāo)準(zhǔn)輸入輸出(stdio)和HTTP/SSE兩種傳輸層,實現(xiàn)雙向?qū)崟r通信。

(2)工作流程

- 初始化連接:客戶端與服務(wù)器協(xié)商協(xié)議版本及能力。

- 請求與響應(yīng):客戶端調(diào)用工具(如查詢數(shù)據(jù)庫)或獲取資源(如文件內(nèi)容),服務(wù)器處理后返回結(jié)果。

- 動態(tài)訂閱:客戶端可訂閱資源變更通知,實時更新上下文。

2)核心功能與優(yōu)勢

(1)功能模塊

- 工具(Tools):可執(zhí)行函數(shù),如調(diào)用API、操作數(shù)據(jù)庫(如LIST_FILES工具)。

- 資源(Resources):提供結(jié)構(gòu)化數(shù)據(jù)(如網(wǎng)頁、數(shù)據(jù)庫記錄),增強模型知識時效性。

- 提示模板(Prompts) :預(yù)定義交互指令,規(guī)范模型輸出格式。

(2)核心優(yōu)勢

- 標(biāo)準(zhǔn)化集成:通過單一協(xié)議替代碎片化API開發(fā),降低維護成本。

- 安全性:支持細粒度權(quán)限控制、數(shù)據(jù)加密及操作審計。

- 靈活性:支持本地文件、遠程API、企業(yè)系統(tǒng)(如Slack、GitHub)等異構(gòu)數(shù)據(jù)源310。

- 擴展性:開發(fā)者可快速搭建服務(wù)器,Anthropic提供Python/TypeScript SDK及預(yù)置服務(wù)器(如Google Drive、PostgreSQL)。

3)MCP協(xié)議成為主流的潛力

(1)技術(shù)優(yōu)勢與效率提升

- 標(biāo)準(zhǔn)化接口:MCP通過統(tǒng)一協(xié)議替代碎片化API開發(fā),顯著降低集成成本。例如,開發(fā)者可在2分鐘內(nèi)通過Cursor連接Google Docs生成產(chǎn)品網(wǎng)頁(PRD),效率提升10倍。

- 動態(tài)上下文交互:支持實時訪問本地數(shù)據(jù)庫、GitHub等資源,增強模型任務(wù)執(zhí)行能力。如Windsurf通過MCP連接Slack和代碼庫,實現(xiàn)自動化開發(fā)流程。

- 安全性設(shè)計:采用本地沙箱機制隔離敏感數(shù)據(jù),避免直接暴露給云端模型,符合企業(yè)級安全需求。

(2)社區(qū)生態(tài)爆發(fā)式增長

- 開發(fā)者活躍度:GitHub已有超1100個社區(qū)貢獻的MCP服務(wù)器,覆蓋文件系統(tǒng)、API調(diào)用等場景,且出現(xiàn)類似“App Store”的第三方商店(如mcp.so)。

- 頭部工具支持:Cursor、Windsurf等主流AI工具已集成MCP,形成“工具+協(xié)議”協(xié)同效應(yīng)。

- 企業(yè)級背書:Block、Apollo等企業(yè)采用MCP,AWS投資40億美元支持Anthropic擴展企業(yè)服務(wù),強化B端市場競爭力。

(3)資本與技術(shù)投入

- Anthropic完成35億美元融資,估值達615億美元,持續(xù)優(yōu)化Claude模型性能(如Claude3.7Sonnet)并擴充算力集群,為MCP提供底層支撐。

- 協(xié)議設(shè)計基于JSON-RPC 2.0,兼容性強,開源社區(qū)可快速擴展功能模塊。

4)潛在風(fēng)險與挑戰(zhàn)

(1)安全性與易用性矛盾

- 本地權(quán)限風(fēng)險:MCP服務(wù)器可非沙盒化訪問文件系統(tǒng),普通用戶難以評估代碼安全性,一鍵部署功能可能引入惡意工具。

- 遠程部署隱患:當(dāng)前僅支持本地運行,計劃2025年推出云端版本,但需解決TLS加密、身份認證等安全問題,否則可能成為中間人攻擊目標(biāo)。

(2)生態(tài)競爭與廠商壁壘

- 閉源廠商主導(dǎo):Anthropic作為協(xié)議提出者,其閉源模型Claude可能擠壓開源模型(如Llama 2)的生態(tài)空間,導(dǎo)致多模型兼容性受限。

- 行業(yè)標(biāo)準(zhǔn)碎片化:OpenAI的Function Calling、Google的Agenda等競品并行,MCP需在技術(shù)迭代中保持差異化優(yōu)勢。

(3)協(xié)議演進與兼容性

- 功能擴展壓力:需平衡現(xiàn)有功能(如數(shù)據(jù)庫查詢)與未來需求(多模態(tài)支持、分布式架構(gòu)),版本兼容性可能引發(fā)生態(tài)分裂。

- 企業(yè)級適配難度:醫(yī)療、金融等場景需高度定制化,MCP需完善權(quán)限控制(如字段級訪問限制)和審計日志功能。

5)結(jié)論

MCP協(xié)議憑借技術(shù)優(yōu)勢與生態(tài)熱度, 極有可能成為主流協(xié)議,但其成功依賴于以下關(guān)鍵因素:

- 安全增強:強化加密傳輸、權(quán)限審計和供應(yīng)鏈審查;

- 生態(tài)開放:吸引更多開源模型和廠商參與,避免閉源壟斷;

- 場景落地:在醫(yī)療、金融等高價值領(lǐng)域驗證可行性,推動企業(yè)級采用。

若上述條件達成,MCP或?qū)⒊蔀锳I與現(xiàn)實世界交互的“數(shù)字接口標(biāo)準(zhǔn)”。

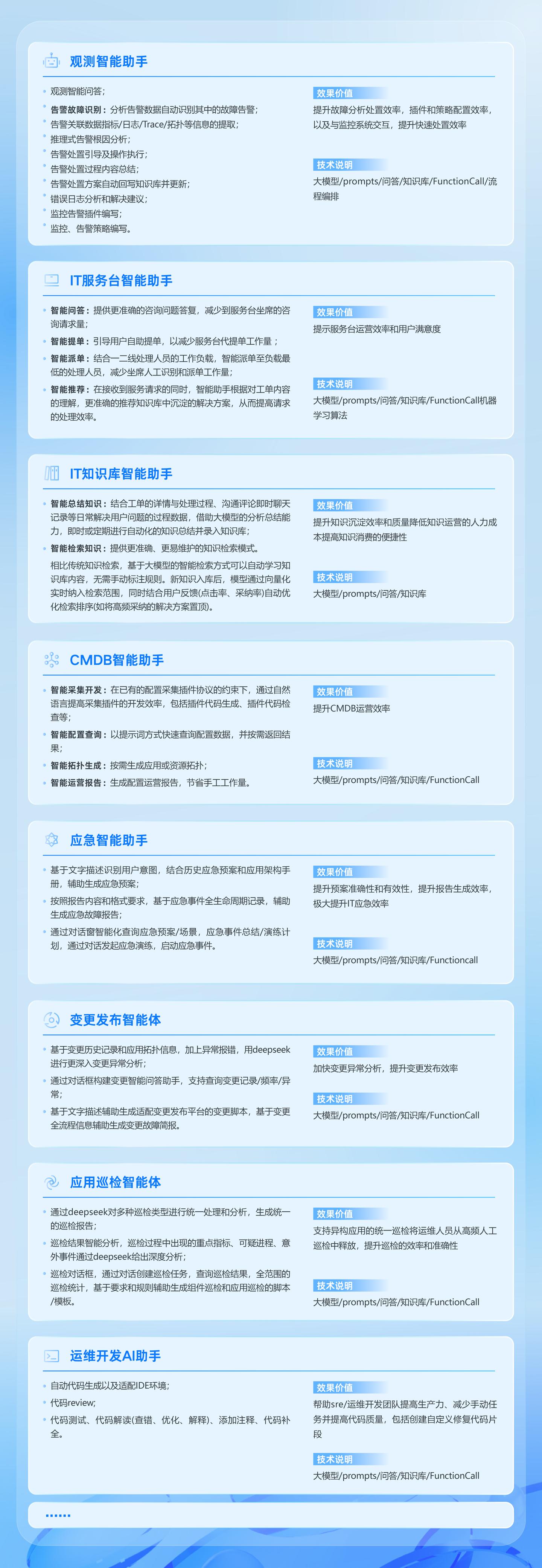

07.附錄二:智能運維場景

相關(guān)文章推薦

CMDB治理:CMDB數(shù)據(jù)消費與應(yīng)用指南

2025-06-27

2025-06-27

查看詳細

1分鐘解鎖開箱即用價值流:研發(fā)效率飆升實戰(zhàn)指南

2025-06-27

2025-06-27

查看詳細

CCI持續(xù)集成平臺:高效集成K8s集群,流水線容器構(gòu)建集群上線

2025-06-27

2025-06-27

查看詳細

嘉為藍鯨CCI持續(xù)集成平臺:Matrix Job 帶你開啟流水線編排 2.0 時代

2025-06-20

2025-06-20

查看詳細

告警管理:如何從零散事件中挖出關(guān)鍵信息

2025-06-13

2025-06-13

查看詳細

嘉為藍鯨CPack制品庫:全新ML模型管理功能,助力AI交付與企業(yè)級DevOps實踐無縫結(jié)合

2025-06-13

2025-06-13

查看詳細